深度学习作为人工智能领域的核心技术之一,在过去几十年中经历了显著的发展。本文将从深度学习的起源、核心技术的演进以及网络开发的关键里程碑进行全面概述,旨在为读者提供一个全局性的技术视角。

深度学习的根源可以追溯到20世纪中叶的神经网络研究。早期,感知机模型由Frank Rosenblatt于1958年提出,它通过模拟人脑神经元的结构,实现了简单的模式识别功能。由于计算能力的限制和理论上的不足,神经网络在20世纪70年代至80年代陷入了第一次低潮期。直到1986年,反向传播算法的提出为神经网络训练提供了有效方法,使得多层网络得以实现,这标志着深度学习的前身——深度神经网络的诞生。

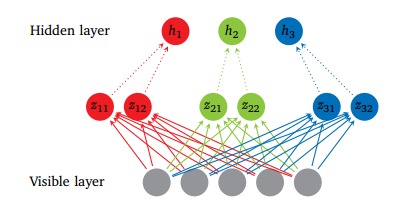

进入21世纪后,随着大数据和计算硬件的飞速发展,深度学习迎来了复兴。2006年,Geoffrey Hinton等人提出了深度信念网络,通过无监督预训练解决了深层网络训练难的问题。2012年,AlexNet在ImageNet竞赛中取得突破性成果,利用卷积神经网络(CNN)大幅提升了图像识别准确率,这成为深度学习技术普及的关键转折点。此后,循环神经网络(RNN)和长短期记忆网络(LSTM)在处理序列数据方面取得进展,而生成对抗网络(GAN)和Transformer架构则在生成模型和自然语言处理领域掀起了革命。

在核心技术发展方面,深度学习从最初的浅层网络演进到包含数十甚至数百层的深度架构。关键技术创新包括激活函数(如ReLU)的优化、正则化技术(如Dropout)的应用,以及优化算法(如Adam)的改进。这些进步不仅提高了模型性能,还降低了过拟合风险。同时,迁移学习和自监督学习等方法的引入,使得深度学习在数据稀缺场景下也能发挥强大作用。

在网络技术开发上,开源框架如TensorFlow、PyTorch和Keras的兴起极大地推动了深度学习的普及。这些工具提供了高效的编程接口,使研究人员和开发者能够快速构建、训练和部署复杂模型。硬件加速技术,如GPU和TPU的广泛使用,显著缩短了训练时间,促进了大规模应用的实现。从计算机视觉到自然语言处理,再到自动驾驶和医疗诊断,深度学习网络技术已渗透到各行各业。

深度学习将继续与强化学习、联邦学习等新兴技术融合,推动人工智能向更通用、更高效的方向发展。尽管面临可解释性、数据隐私等挑战,但通过持续的创新,深度学习有望在智能系统中扮演更核心的角色。从早期神经网络到现代深度架构,深度学习的发展历程体现了技术、数据和算法的协同进化,为人类社会的智能化转型提供了坚实基础。